Индикатор производительности или PI

22 июля 2016 г. | Категория:

Компания Green Grid, известная в отрасли дата-центров созданием и введением показателя эффективности использования энергии (PUE, power usage effectiveness), разработала новую метрику для операторов ЦОДов – индикатор производительности (PI, Performance Indicator).

Green Grid представили миру PUE в 2007 году. С того момента эта метрика получила широкое распространение в отрасли ЦОДов. Это стало не только простым способом измерения электрического и механического КПД инфраструктуры дата-центра, но и методом коммуникации с теми, кто не является специалистом в отрасли: с помощью PUE им проще объяснить степень эффективности или неэффективности инфраструктуры дата-центра.

Индикатор производительности базируется на PUE, но добавляет две дополнительные меры измерения эффективности инфраструктуры: насколько хорошо система охлаждения справляется со своей работой в нормальных для этого условиях и насколько хорошо эта система разработана для бесперебойной работы в случае возникновения внештатной ситуации.

В отличие от PUE, которое измеряет как холодоснабжение, так и электроснабжение, PI основывается исключительно на системах охлаждения. Компания Green Grid ввела эту меру измерения для дата-центров, чтобы обратить внимание на тот факт, что операторов ЦОДов волнует не только их общая эффективность. Да, это немаловажный фактор, но Green Grid ставят с ним на одну полку производительность систем охлаждения и их отказоустойчивость.

Все три показателя – эффективность, производительность, отказоустойчивость – неразрывно связаны. Вы можете улучшить один, но вместе с этим негативно повлиять на два других.

К примеру, в результате повышения температуры в дата-центре вы можете повысить энергоэффективность ЦОДа за счет уменьшения количества холодного воздуха, предоставляемого системой охлаждения, но чуть только температура начнет превышать норму, и некоторое ИТ-оборудование перестанет работать. В то же время вы можете сделать систему более устойчивой к простоям за счет улучшения резервирования, но это зачастую оказывает негативный эффект на эффективность, так как появится новое оборудование, которому понадобится питание, что повлечет за собой увеличение риска возможности потерь электричества. Одновременно со всем этим, больше оборудования означает больше точек отказа системы, что опять же плохо сказывается на отказоустойчивости.

Разные компании по-разному оценивают важность этих трех компонентов, считает Марк Сеймур технический директор проектов Green Grid и один из главных создателей PI. Как он отмечает, это не проблема для таких гигантов, как Google или Facebook, если один или пара серверов в кластере выйдут из строя. Они могут себе позволить не жертвовать эффективностью всего ЦОДа ради предотвращения подобных случаев. Однако для брокерской компании, занимающейся сиюминутными продажами, напротив, «упавший» сервер может означать значительную потерю прибыли. В этом случае компания предпочтет мириться с дополнительной степенью неэффективности, чем допустить подобное.

Индикатор производительности измеряет все эти три параметра для каждого дата-центра и, что самое главное, покажет, как изменение любого из них влияет на остальные. Это еще одно принципиальное отличие от PUE: PI использует весь свой потенциал и на его основе можно делать прогнозы, чем его предшественник похвастаться не может.

Святая Троица измерений дата-центра

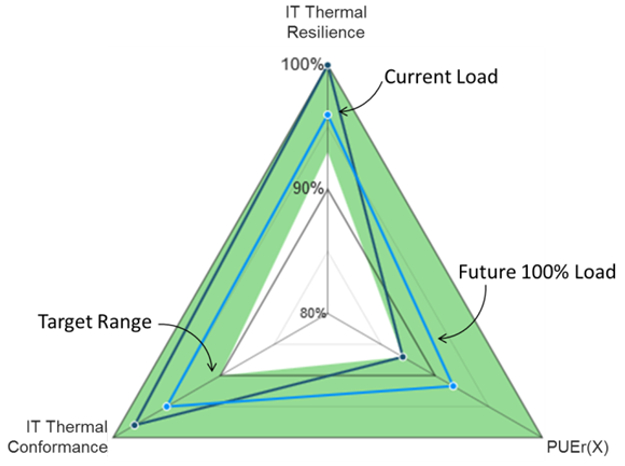

Тремя величинами, составляющими PI, являются коэффициент PUE или PUEr (PUE ratio), тепловое соответствие ИТ-инфраструктуры и тепловая устойчивость ИТ-инфраструктуры. Их соотношение выражается в следующей диаграмме:

Коэффициент эффективности использования энергии (PUEr) выражает, насколько далеки реальные показатели дата-центра от целевого PUE. В Green Grid выделили семь диапазонов этой величины от A до G, каждая из которых представляет разный уровень эффективности. Соответственно A – самый высокоэффективный, от 1.15 до 1.00, а G – самый низкоэффективный, от 4.20 до 3.20.

Каждый ЦОД так или иначе попадает под одну из этих семи категорий, и этот коэффициент показывает, насколько далеко реальные показатели находятся от нижней отметки целевого диапазона (напоминаем, что, чем ниже PUE, тем выше эффективность).

К примеру, если PUE дата-центра равняется 1.5, что попадает в диапазон С (1.63 – 1.35), а целью является достижение высшего показателя в данном диапазоне, то необходимо разделить 1.35 на 1.5 – в результате получается PUEr равный 90%. Правильное обозначение будет «PUEr(C)=90%».

Тепловое соответствие ИТ-инфраструктуры показывает соотношение ИТ-оборудования, которое работает в диапазонах температур, установленных ASHRAE (Американское общество инженеров систем теплоснабжения, искусственного охлаждения и кондиционирования воздуха). Другими словами, эта величина показывает, насколько хорошо система охлаждения выполняет работу, ради которой была предназначена. Для определения этой величины необходимо разделить количество оборудования, работающее в установленных диапазонах, на все количество оборудования холодоснабжения в дата-центре.

Компания Green Grid приняла решение использовать рекомендации ASHRAE, но операторы ЦОДов могут сами определять приемлемые для них температурные диапазоны или руководствоваться требованиями производителя системы без какой-либо потери полезности метрики.

Тепловая устойчивость ИТ-инфраструктуры показывает, сколько холодного воздуха получает ИТ-оборудование в рамках допустимых или рекомендованных ASHRAE диапазонов в случае неработоспособности резервных блоков системы охлаждения вследствие неисправности или планового технического обслуживания. Иными словами, если вместо 2N или N+1 остается только элемент N, какова вероятность простоя оборудования?

Вычисления будут такие же, как и с тепловым соответствием ИТ-инфраструктуры, единственное отличие состоит в том, что производить эти вычисления необходимо во время отключения резервных блоков. Конечно, в Green Grid не настаивают намеренно их отключать с целью вычислений, напротив, компания советует их производить во время технического обслуживания или, что даже лучше, во время плановых проверок оборудования, когда соответствующим программным обеспечением моделируется внештатная ситуация.

Кроме того, подобное ПО в комбинации с PI может быть мощным инструментом для принятия решений об изменениях в ЦОДе. К примеру, эта величина может показать, как добавление дополнительных серверов может сказаться на эффективности, отказоустойчивости и холодопроизводительности.

Четыре уровня PI

В Green Grid ввели дополнительно четыре уровня оценки по показателю эффективности от наименее до наиболее точного.

Уровень 1

Не все ЦОДы оснащены температурными сенсорами на каждом сервере, поэтому первый уровень PI является начальным уровнем оценки и основан на измерениях температуры в стойке. В ASHRAE рекомендуют принимать показатели температуры в трех точках на каждую стойку, чего вполне достаточно для первого уровня.

Уровень 2

Как и первый уровень, базируется на измерениях температуры, но в этом случае они должны проводиться с каждого сервера. Для этого дата-центру необходимо оснащение соответствующих тепловых сенсоров и система мониторинга DCIM или иная другая.

Уровень 3

Этот уровень подходит тем, кому необходимо предварительное моделирование. Здесь оператор ЦОД получит оценку по PI, основанную на измерениях температуры в стойке, но они будут использоваться, чтобы создать модель будущих состояний оборудования и получить общее представление о поведении всей системы при имплементации различных изменений. Это дает возможность для более качественного проектирования.

Кроме того, это позволит понять, насколько дата-центр может справиться с предназначенной для него нагрузкой. К примеру, ЦОД работает лишь на 50% своей мощности, что составляет 2 МВт. Если вы создаете соответствующую модель, имитируете работу на полную мощность и понимаете, что необходимые показатели теплового соответствия или тепловой устойчивости инфраструктуры достигаются при мощности 1,8 МВт, то это значит, что вы зря тратите деньги.

Уровень 4

Очень схож с третьим уровнем, но в этом случае моделирование будет более точным. Оно будет основано на измерениях температур из максимально возможного количества точек по всему ЦОДу: серверов, перфорированных плиток, притока обратного воздуха и т.д. Это необходимо для того, чтобы модель с максимальной точностью могла продемонстрировать состояние дата-центра.

Операторы ЦОД могут выбирать любой из уровней оценки по PI. Это будет зависеть от самого дата-центра и его бизнес-задач.

Теги: PI, Green Grid, PUE, Индикатор производительности

|

ПОСЛЕДНЕЕ

ПОСЛЕДНЕЕ

Чтобы оставить свой отзыв, вам необходимо авторизоваться или зарегистрироваться

Комментариев: 0